WebスクレイピングサービスShtockDataは、Webサイトを周期的に巡回し、Webページ上のデータを抽出し、収集するサービスです。データは、標準化された形式に変換され、クラウド上のDWH(データウェアハウス)に格納されます。

Webデータから取得可能なデータには、画像やテキスト(商品価格、レビュー、企業情報、ニュース記事)があり、市場変化の検出や競合他社の商品やサービスの比較(価格や性能)等に使用されています。

WebスクレイピングサービスであるShtockDataにより、価格戦略、商品企画、海外市場調査、企業情報の抽出、求人状況や不動産情報のリアルタイムな把握、様々なマーケティング活動を支援し、組織のDX化を推進します。

「ソフトウェアビジネス新市場 2021年版」にて、WEBクローリングシェアNo.1を獲得いたしました。

多様な業種のお客様に導入いただいています。

ビッグデータ時代の新しいインフラとして多くの企業・組織に継続的に活用されています。

並列クローリング 並列クローリング |

並列クローリングにより数千万・数億ページ規模のクローリングにも対応 |

|---|---|

あらゆるサイトへのクロール対応 あらゆるサイトへのクロール対応 |

Keywalker.jsという独自開発のブラウザ自動操作言語により、動的なサイトからも情報の抽出が可能 |

柔軟なクローリング設定機能 柔軟なクローリング設定機能 |

|

様々な文書ファイル形式を取得可能 様々な文書ファイル形式を取得可能 |

HTML、RSS、SITEMAP、PDF、Office文書、他 |

| 可視化(オプション) | 取得したデータは、Tableau(BIツール)と連携することで分析・可視化 |

| 納品データ形式 | Json・XML・貴社指定フォーマットに変換 |

| データ連携 | 収集データを貴社のご指定方法で、システムへ直接連携 |

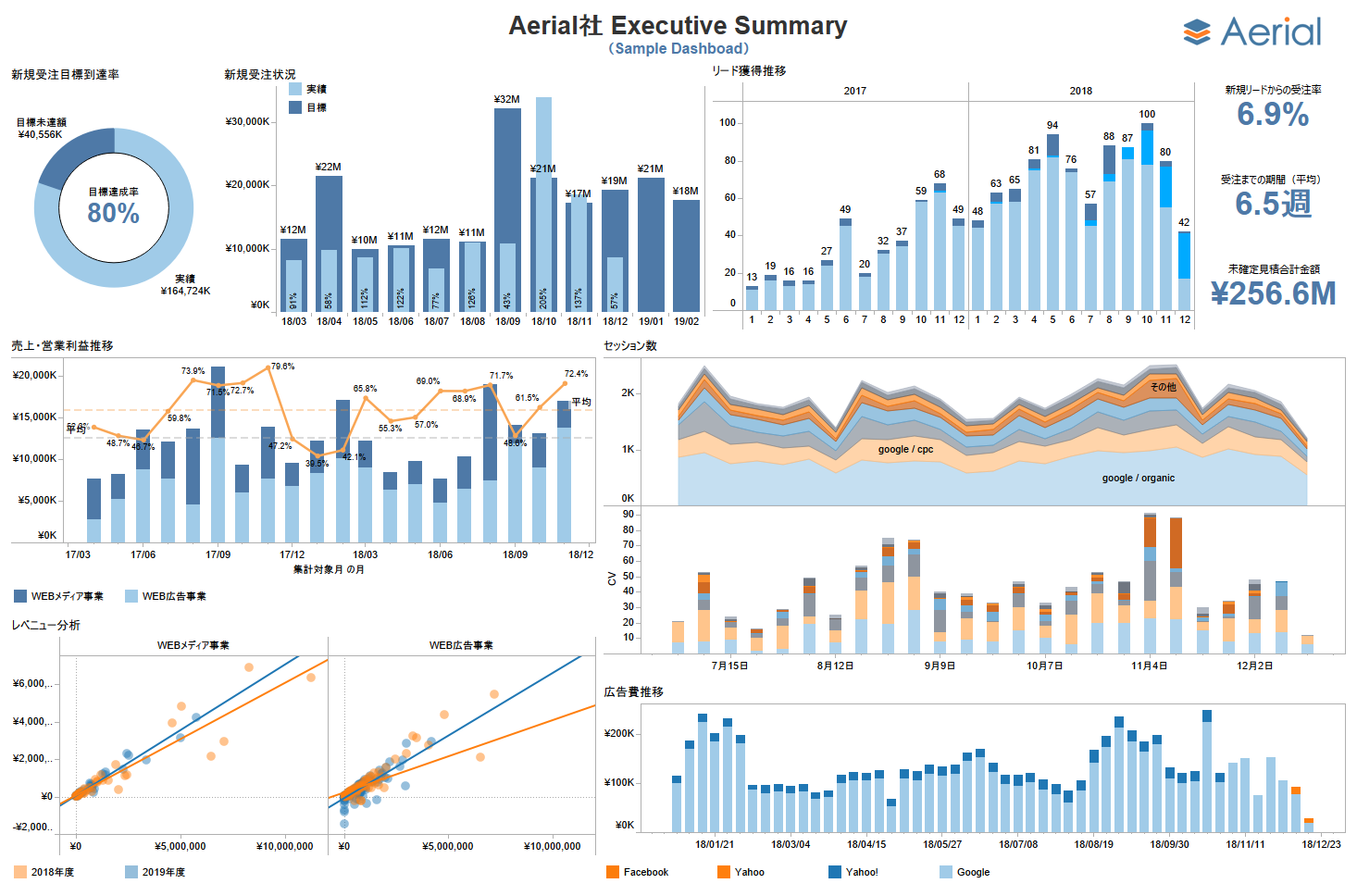

Webクローリング、Webスクレイピングで収集したデータを見える化することで ビジネス環境の変化をリアルタイムに把握することができます

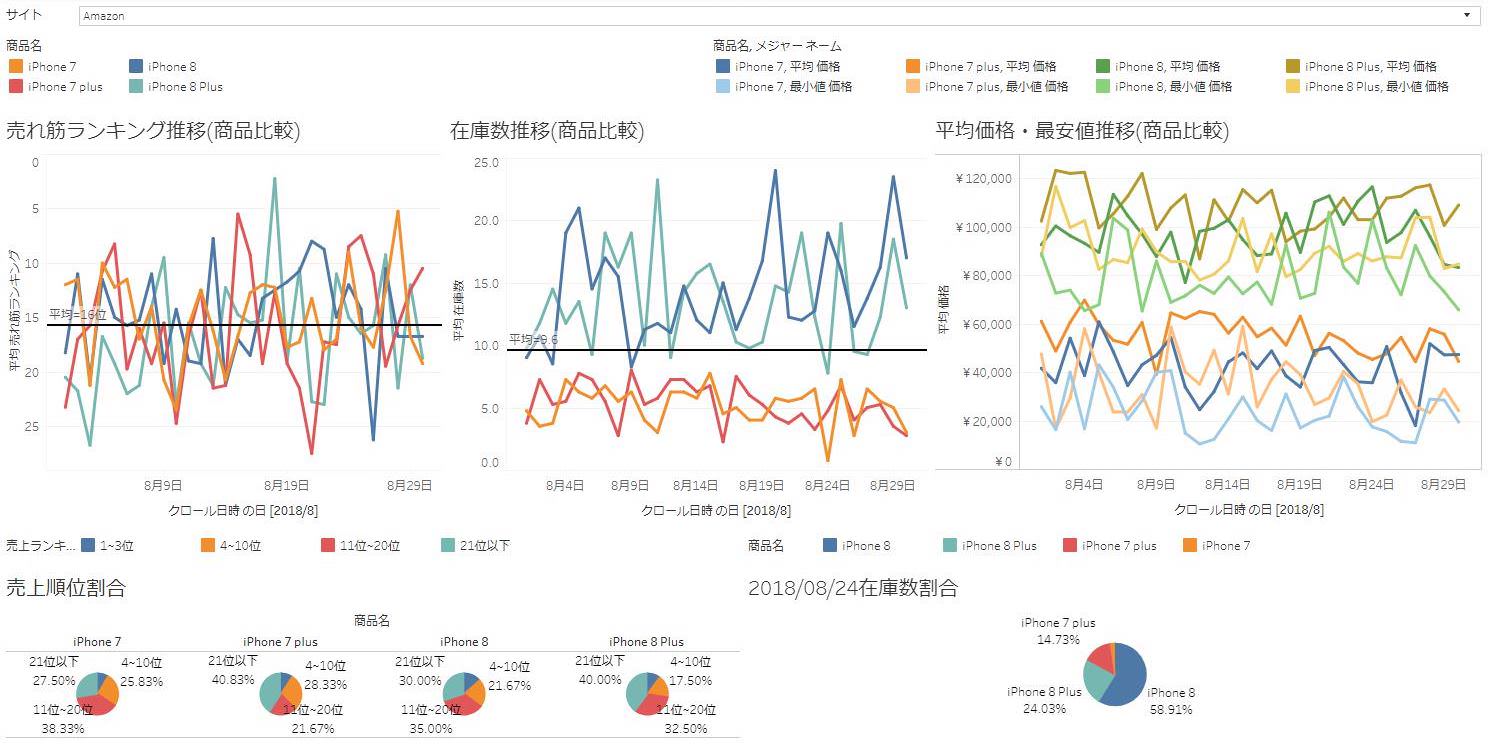

競合他社の商品情報を収集できます。画像やカテゴリ、ブランド、商品説明、セール情報、ポイント数、在庫、カラー等も取得できます 事例詳細

ShtockDataで取得した情報は、グラフに変換できます。商品の価格や株のデータをグラフにして、可視化することで価格の変動を直感的に把握することで、ビジネスシーンに活用可能です。 事例詳細

Webページ(テキスト、画像、HTMLソース)の更新・変化をとらえて通知するサービスです。URLをセットするだけのカンタン設定。2週間無料でお試しいただけます。 事例詳細

ECやSNSから商品画像を収集します。収集した画像は、ハッシュタグやコメント、画像処理の結果を関連付けすることで、商品の流行分析や商標の不正使用調査、広告露出調査、規約等の違反のチェックなどに活用されます。 事例詳細

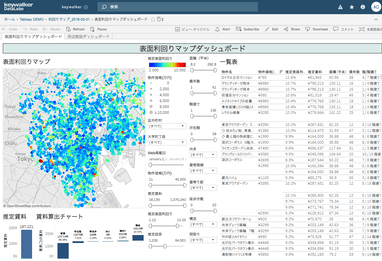

不動産ポータル等から物件情報を収集します。収集した情報をもとに最適な家賃や仲介時の最適な買取・売却価格の推論、顧客への提案資料として活用されます。 事例詳細

ECサイトやSNSに記載された競合他社や自社の商品、サービス、施設等の口コミやレビューの情報を収集します。収集したデータは商品の企画等に活用されています。 事例詳細

企業HPの会社概要や求人情報から条件に合わせて企業データを収集できます。リアルタイムにリード獲得のための営業リストや金融機関向けマッチングデータを提供します。 事例詳細

キーウォーカーのWebクローリング技術により大量にデータを収集し、Webスクレイピングで必要となるデータを抽出することでし、分析、可視化、機能追加、運用までの一連のソリューションを提供しています。

これまでのマーケティング担当者の「勘や経験」という主観的な根拠から導き出した施策に比べ、データに高い精度を期待できます。

Webクローリング、Webスクレイピングによって収集した膨大なデータは、BigQuery等に継続的に蓄積し、整形処理されたデータをBIツールである Tableauや15年間研究を行ってきた人工知能等の技術を活用して、様々な角度から分析を行います。

| データ収集・整理 | データ蓄積 | 分析・可視化/機能構築 | 運用 | |||||

| Webクローリング | データハンドリング | データベース | 分析・可視化 | 機能構築 | 価格の最適化計算

競合価格比較・分析 |

|||

|

|

|

|

|

|

|

|

|

商品データ/店舗データ/企業情報/求人情報/不動産情報/ニュース/テレビ番組/SNS/口コミ/Webアナリティクス/人口統計データ

|

|

BIツールやAIを活用し データを分析・可視化 AI、統計分析 |

アラート機能/Webページの差異検出/キュレーションポータル構築 |

|

||||

| ShtockData | 他社 | |

| 取得データの可視化 | ||

| BASIC認証 | ||

| ログイン | ||

| テキスト入力 | ||

| フォーム送信 | ||

| サイト内検索 | ||

| フレーム内のパース | ||

| クッキーの使用 | ||

| スクロール対応 | ||

| HTMLにない情報の取得 | ||

| JavaScript対応 | ||

| 画像のダウンロード | ||

| PDFのダウンロード | ||

| エクセルファイルのダウンロード | ||

| CSVで出力 | ||

| XMLで出力 | ||

| JSONで出力 | ||

| スケジューリング | ||

| スクリーンショット | ||

| メール通知 |

下記リンク(または電話)よりお問い合わせフォームへの入力をお願いいたします。 担当者よりご連絡さしあげます。

取得対象サイト、取得項目、データ取得頻度、データ提供形式についてヒアリングいたします。

対象サイトについて調査をおこない、お見積もりをご提供します。

クローラ設定(最短3営業日程度)

データ納品、運用開始

WEBクローラーのQ&Aはこちらから