言語処理学会第27回年次大会(NLP2021)が、3/15~3/19に開催されました。弊社は本大会に、最新の技術動向の把握や、スポンサー展示を通して参加者の皆様と交流することを目的として、参加させて頂きました。

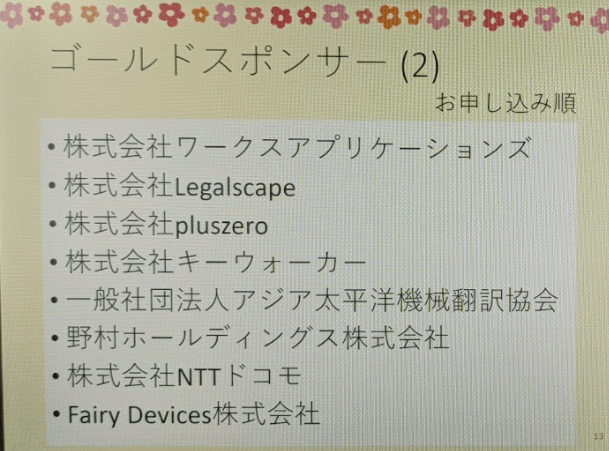

本記事はその参加レポートとなります。なお今回、初めてスポンサー(ゴールドスポンサー)としての参加となります!

言語処理学会年次大会について

言語処理学会年次大会は、自然言語処理および関連領域に携わる研究者や学生が研究成果発表の場として、また国際的な研究交流の場として集う大規模なイベントです。

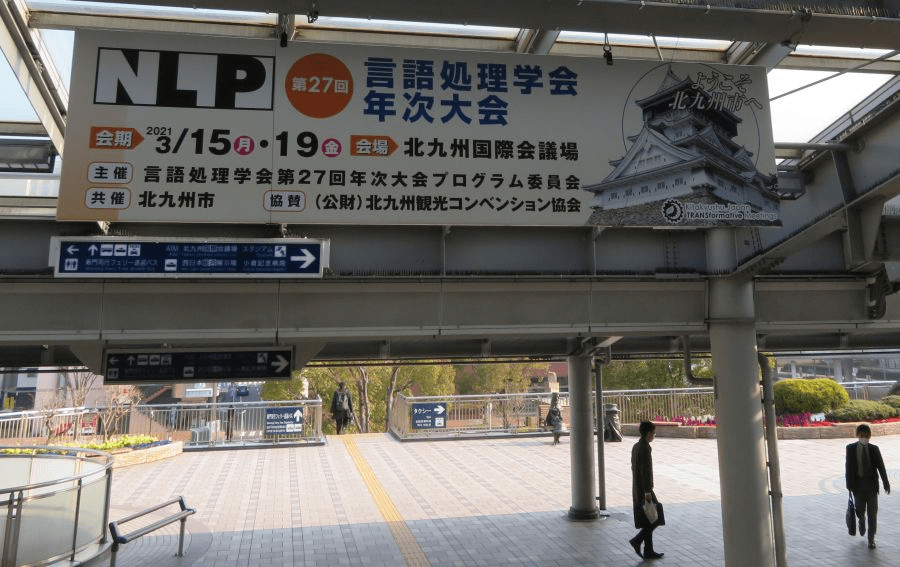

本大会は、北九州国際会議場での開催を予定していましたが、社会情勢を考慮し、参加者はZoomとSlackを活用してのオンラインでの参加でした。参加者はオンラインでしたが、小倉駅の新幹線口には歓迎の横断幕が掲げられていたようです。 https://twitter.com/nlp2021/status/1371274606661705734?s=20

なお、本大会の全参加者は1509人だったようです。また、361件もの発表論文がありました。3/15にチュートリアルとして著名な先生方の講演があり、本会議は3/16~3/18、3/19はワークショップの開催といった日程でした。

また弊社は、ゴールドスポンサーとして参加し、聴講だけでなくスポンサー展示も行いました。

聴講内容について

今回聴講した中で特に印象深かった発表をご紹介させて頂きます。

こちらがNLP2021プログラム

A1-3 単語の重要度に応じてパラメタ数可変な単語分散表現の学習

露木浩章, 小川哲司, 小林哲則, 林良彦 (早大)

単語の分散表現は、ニューラルネットワークベースのモデルにも使用されており自然言語処理を行うにあたって欠かせない技術となっています。近年多くの場で利用されているBERTにも単語の分散表現が用いられています。しかし、BERTといった多くのモデルで莫大な計算量が課題になっているので、パラメタ数削減によって受けられる恩恵は大きいのではないかと思って聴講しました。

概要

自然言語処理モデルにおける単語分散表現のパラメタ数を単語の重要度によって可変にすることで、必要メモリの削減を目的とした研究です。単語の重要度はモデルに解かせるタスクに依存し、感情分析タスクの場合、感情語であればパラメタ数を多く割り当てるような手法となっています。

結果としてモデルの精度を落とすことなく単語分散表現の圧縮を可能としていました。

所感

従来手法の単語ベクトルのパラメタ数の削減では、出現頻度を基準として単語の削減が行われます。しかし、この手法では削減される単語に感情語が含まれるという問題を指摘し、それを解決する方法として重要度を扱っている部分は、人間の文章理解の直感に即していてかなり納得感がありました。

一方で、出現頻度によるパラメタ数への影響もわずかに感じられたため、出現頻度の影響も気になりました。言語処理モデルにおいてパラメタ数の削減は精度向上に繋がる側面もあるため、今後の研究において精度向上も行えるか気になりました。

単語の重要度ごとに圧縮された分散表現を用いて、単語の類似度計算といった従来のタスクを行った結果にも興味があります。

C5-3 知識グラフエンベディングのためのリレーションパスルールによるトランスダクティブデータ拡張

廣瀬雄士 (NAIST), 新保仁 (千葉工大), 渡辺太郎 (NAIST)

知識グラフは、単語間の関係を表すことのできる技術であり、BERTなどのモデルでは解くことが難しいとされている質問応答や関係性抽出タスクに親和性が高い技術なので以前より注目していました。

概要

知識グラフを補完するエンベディングモデルを学習させる際に、トランスダクティブ学習によってデータを拡張することでモデルの精度を向上させるという研究でした。また、その学習の際のエンティティの予測は、リレーションパスルールによって予測を行い訓練データを拡張していくという手法でした。結果として、データを拡張を行ったモデルの精度は向上したことが確認されていました。今後の研究として、通常の学習設定でのリレーションパスルールによるデータ拡張を課題としていました。

所感

知識グラフとは、エンティティと関係から成り立っています。例えば、徳川家康というエンティティと岡崎城というエンティティがある場合、その2つの間には出生地というリレーションが存在するという関係を表したものです。この知識グラフを補完するための手法としてトランスダクティブ学習を用いていました。

トランスダクティブ学習とは半教師学習であり、問題と回答がそろっているペアと問題のみで回答が未知のペアから未知の回答を予測するという手法です。知識グラフの補完に対してこの手法を用いることでデータを拡張して、拡張したデータを用いてモデルを学習させていました。

結果として精度向上が確認されましたが、データの種類によって改善幅に差があったため今後の課題とされていました。今後は弊社でも関係性抽出に取り組みたいと持っているので注目していきたい分野になっています。

C1-3 自然言語処理技術によるSDGs 関連特許技術の「見える化」

前原義明, 久々宇篤志, 長部喜幸 (Japio)

SDGsの文章分類は、以前に弊社でも研究開発の一環で、マルチラベルでの分類に取り組んだことがありました。

そのため、本論文ではどのように分類しているのかとても興味があり聴講させて頂きました。

概要

特許技術の文献に対して、SDGsに関する文章分類を行う研究です。文章分類にはBERTを用いていました。BERTに入力する文章は、512トークンの制限や、特許の特徴が現れやすいといったことから、「発明の課題」についての記載がある箇所を対象としたようです。

SDGsは1つの文章でも、複数の項目に該当する(マルチラベル)ことが考えられますが、まずは1つのラベルのみで実施した結果の報告となっていました。

所感

特許技術の文章に対して分類することで、各国や各企業が技術面でどの程度SDGsに貢献しているのかを可視化することができるため、非常に有用な技術なのではないかと感じました。また、特許ドメインに特化したモデルの結果が見れるのも、非常に面白いと感じました。今後どのようにモデルの改良が進むのか、とても興味深いです。

我々が取り組んだ際には、SDGsの文章は各ラベルに属する定義が難しく、アノテーションに苦労したり、教師データに似たような文章が含まれるラベル(No.7と13など)もあるため、どのように分類するのが良いかといったところに、課題を感じていました。

最新の技術をキャッチアップして、精度を向上させていきたいですね。

P4-12 Tokenizerの違いによる日本語BERTモデルの性能評価

築地俊平, 新納浩幸 (茨大)

BERTを使う際に、同じtokenizerを使うことに少々めんどくささを感じていました。

別のtokenizerを使ったら、どの程度性能が落ちるのか、考えたことはありましたが、実際に試したことはありませんでした。この研究は実際にそれをやってくれていたので、聴講させて頂きました。

概要

BERTにおいてtokenizerを変更した場合、性能にどの程度影響が出るのかを検証した研究です。BERTは東北大版を使用しており、tokenizerにはMeCab+NEologdやJuman++、Sudachi、SentencePieceなどで比較していました。また、性能評価のタスクは文章分類です。結果としては、SentencePieceのみが大幅に性能を落としており、他のtokenizerでは、あまり変化がないようでした。

所感

結果は想像していた以上に、精度の差がないと感じました。今回は文章分類でしたが、固有表現抽出など、文章分類以外のタスクでどうなるかも興味がありますね。また、tokenizerの違いで[UNK]がどの程度出るのかや、[UNK]の個数と性能の下がり具合の関係なども見てみたいなと思いました。

余談ですが、最近tokenizationを必要としない「CANINE」といった手法も発表されているようです。自然言語処理では、tokenizerに依存することも多いため、それが解消されると思うと注目しておきたいです。

A7-2 Transformerの混ぜる作用と混ぜない作用

小林悟郎 (東北大), 栗林樹生 (東北大/Langsmith), 横井祥, 乾健太郎 (東北大/理研)

まず、この発表のタイトルに惹かれました。

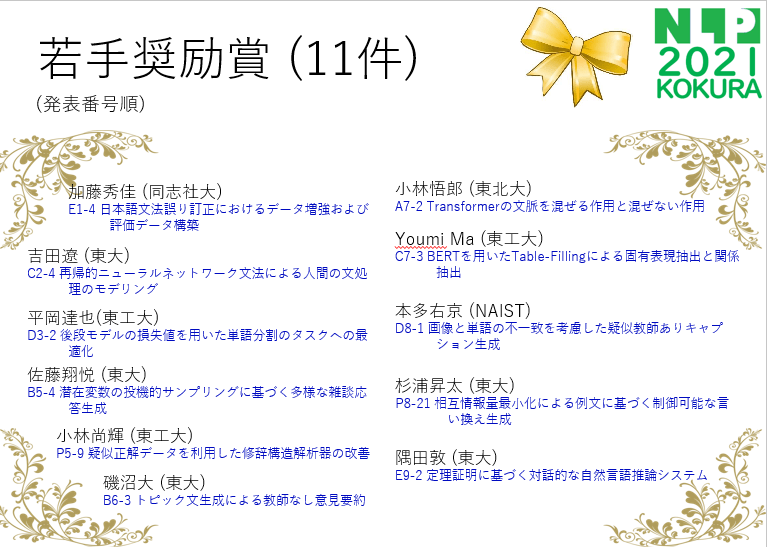

実際にどんな内容なのか予稿集を見てみると、混ぜる作用がどの程度支配的であるのかを調査されていたので、面白いテーマだと思い、聴講させて頂きました。また、本論文は若手奨励賞を受賞されていました。おめでとうございます!

概要

Transfoermerの理解を目的としている研究で、注意機構(周囲のベクトルを混ぜる作用)だけでなく、残差結合(自身のベクトルを残す作用)にも注目し、どちらの作用が支配的なのかを調査していました。混ぜ合わせの強さは、ベクトルのノルムで比較していました。結果としては、混ぜる作用よりも残す作用のほうが支配的だったようです。各層とトークン種類ごとの傾向も調査しており、[MASK]には比較的強く情報を集めるなどの結果も出ていました。

所感

普段BERTを使うときは、どうしてもモデルの出力結果(性能)を優先してしまうので、この発表はとても面白かったです。今回は事前学習済みBERTのみで検証していましたが、今後はFine-tuningしたBERTやRoBERTaなど、他のモデルでも検証するとのことでした。結果が楽しみですね。

我々も、こういった研究の情報をキャッチアップし、より深く理論やモデルを理解することを目指したいです。

おわりに

オンラインで開催される学会に初めて参加しましたが、戸惑うことなくスポンサー展示および聴講をすることができました。懇親会はGather townでの開催で、200人が8チームに分かれ、各チームが1文字を作るというイベントもありました。

昨晩の #NLP2021 懇親会では https://t.co/FgjN2wlH7h に集まって200人が8チームに分かれ、各部屋で人文字を作るというイベント。最も美しかったのは、アバターを統一させてハート型を作って❤マークを出したDチームでした。これをきっかけに歓談ができて、新しいオンライン懇親会の形が生まれました。 pic.twitter.com/F5XmQ8caMF

— NLP2021 (@nlp2021) March 17, 2021

様々な工夫をしていただいたおかげで、かなり盛り上がった年次大会だったのではないかと思います。ご準備頂いた運営の皆さんには、感謝申し上げます。

また、弊社のブースにお越しいただいた皆様とは、楽しくかつ有意義なお話をさせて頂きました。お越しいただいた皆様、ありがとうございました。来年の開催も非常に楽しみにしております!

最後になりますが、弊社は自然言語処理のプラットフォームを開発しており、自然言語処理エンジニアを募集しております。

ご興味のある方は、こちらからご応募下さい!

https://recruit.keywalker.co.jp